# d/acc:一年後的回顧與展望去年,我寫了一篇關於技術樂觀主義的文章,闡述了我對技術的熱情以及它可能帶來的巨大效益,同時也表達了對一些特定問題的審慎態度,尤其是超級智能AI可能帶來的風險。文章的核心觀點是倡導一種去中心化、民主且差異化的防御性加速理念。既要加速技術發展,又要有針對性地關注那些能提升防御能力而非破壞能力的技術,並致力於分散權力,避免權力集中在少數精英手中。一年過去了,這些想法有了顯著的發展和成熟。我在"80,000小時"平台上分享了這些想法,收到了很多反饋,大多是積極的,當然也有一些批評。這項工作持續推進並取得了實質性成果:可驗證開源疫苗領域有了進展;人們對健康室內空氣價值的認知不斷深化;"社區筆記"持續發揮積極作用;預測市場作爲信息工具迎來了突破之年;零知識證明在政府身分識別和社交媒體領域得到應用;開源成像工具在醫學和腦機接口領域獲得應用,等等。去年秋季,我們舉辦了首個重要的d/acc活動:"d/acc發現日"。活動匯聚了來自d/acc各個領域(生物、物理、網路、信息防御和神經技術)的演講者。長期致力於這些技術的人們更好地了解了彼此的工作,外部人士也越來越意識到這一更宏大的願景:推動以太坊和加密貨幣發展的價值觀可以拓展到更廣闊的世界。# d/acc的內涵與外延 d/acc的核心思想簡潔明了:去中心化、民主且差異化的防御性加速。構建能夠促使攻防平衡向防御傾斜的技術,並且在實施過程中不依賴於將更多權力交予中央權威機構。這兩個方面之間存在着內在的緊密聯繫:任何一種去中心化、民主或自由的政治結構,在防御易於實施時往往能夠蓬勃發展,而在防御面臨重重困難時則會遭遇嚴峻挑戰。理解嘗試同時實現去中心化、防御性和加速性的重要意義的一種方式,是將其與放棄這三個方面中的任意一個所產生的理念進行對比。去中心化加速,但忽視"差異化防御"部分,這類似於成爲一名有效加速主義者(e/acc),但同時追求去中心化。這種方式或許能夠避免特定羣體對全球人類實施獨裁統治的風險,但它未能解決潛在的結構性問題:在一個有利於進攻的環境中,始終存在着災難降臨的持續風險,或者有人會將自己定位爲保護者,並永久性地佔據統治地位。差異化防御加速,但忽略"去中心化和民主",爲了實現安全目標而接受集中控制,這對一部分人始終具有一定的吸引力。然而,集中控制存在一個程度的問題。一種通常被忽視但仍然有害的相對溫和的集中控制形式,體現在生物技術領域對公衆監督的抵制,以及允許這種抵制行爲不受挑戰的閉源規範。去中心化防御,但排斥加速,這本質上是試圖減緩技術進步或推動經濟衰退。這種策略面臨着雙重挑戰。首先,總體而言,技術和經濟增長對人類而言是極爲有益的,任何對其的延遲都會帶來難以估量的代價。其次,在一個非極權主義的世界中,停滯不前是不穩定的:那些"作弊"最多,能夠找到看似合理的方式繼續推進發展的人或羣體將會佔據優勢。通過d/acc,我們致力於實現以下目標:- 在當今世界日益部落化的趨勢下堅守原則,而不僅僅是盲目地構建各種事物。- 認識到指數級的技術進步意味着世界將變得極爲奇特,並且人類在宇宙中的總體"足跡"必然會不斷增加。我們保護脆弱的動物、植物和人羣免受傷害的能力必須持續提升,而唯一的出路便是勇往直前。- 構建能夠切實保護我們的技術,而不是基於"好人(或好的AI)掌控一切"的假設。我們通過構建在用於構建和保護時自然比用於破壞時更爲有效的工具來達成這一目標。思考d/acc的另一種視角是回歸到21世紀00年代末歐洲海盜黨運動的一個框架:賦權。我們的目標是構建一個能夠保留人類能動性的世界,實現消極自由,即避免他人對我們塑造自身命運的能力進行積極幹預,同時實現積極自由,即確保我們擁有知識和資源去踐行這一能力。# 第三維度:生存與繁榮的協同發展在去年的文章中,d/acc特別聚焦於防御性技術:物理防御、生物防御、網路防御和信息防御。然而,單純的去中心化防御並不足以構建一個偉大的世界:我們還需要一個具有前瞻性的積極願景,明確人類在獲得新的去中心化和安全性之後能夠實現何種目標。在各個領域中存在着一個一致的模式,即那些能夠幫助我們在某一領域"生存"的科學、思想和工具,與能夠助力我們"繁榮"的科學、思想和工具密切相關。以下是一些具體例子:- 衆多近期的抗新冠研究聚焦於病毒在體內的持續存在,這被視爲長新冠問題的一個關鍵機制。近來,也有跡象表明病毒持續存在可能是阿爾茨海默病的致病因素。- 低成本和微型成像工具在治療微血栓、病毒持續存在、癌症等方面具有強大的潛力,同時也可應用於腦機接口領域。- 推動構建適用於高度對抗性環境的社會工具和合理合作環境的社會工具的理念極爲相似。- 預測市場在高合作和高對抗環境中均具有重要價值。- 零知識證明及類似技術在保護隱私的同時對數據進行計算,既增加了可用於科學研究等有益工作的數據量,又增強了隱私保護。- 太陽能和電池對於推動下一波清潔經濟增長意義非凡,同時在去中心化和物理彈性方面也表現出色。除此之外,不同學科領域之間還存在着重要的相互依存關係:- 腦機接口作爲一種信息防御和協作技術至關重要,因爲它能夠實現我們思想和意圖的更精細交流。- 許多生物技術依賴於信息共享,而在諸多情況下,人們只有在確信信息僅會用於特定應用時才願意共享。這依賴於隱私技術。- 協作技術能夠用於協調對其他任何技術領域的資助。# 難題:AI安全、緊迫時間線與監管困境去年我的文章所收到的最具說服力的反對觀點來自AI安全社區。其論點爲:"雖然我們有半個世紀的時間來發展強AI,我們可以集中精力構建所有這些有益的事物。但實際上,看起來我們可能僅有三年時間發展到通用AI,再過三年發展到超級智能。因此,如果我們不想讓世界陷入毀滅或以其他方式陷入不可逆轉的困境,我們不能僅僅加速有益技術的發展,還必須減緩有害技術的發展,這意味着需要通過可能會觸怒權勢階層的強有力監管措施。"對新監管持謹慎態度的理由:去年,主要的AI監管提案是加利福尼亞州的SB-1047法案。SB-1047要求最強大模型的開發者在發布前採取一系列安全測試措施。此外,如果AI模型開發者未能足夠謹慎,將對其追究責任。許多批評者認爲該法案"對開源構成威脅";我對此持有異議,因爲成本閾值意味着它僅影響最強大的模型。然而,回顧過去,我認爲該法案存在一個更爲嚴重的問題:如同大多數監管措施一樣,它過度適應了當前的情況。最有可能對AI超級智能毀滅場景負責的行爲者:實際上,最有可能對AI超級智能毀滅場景負責的行爲者是軍隊。正如我們在過去半個世紀的生物安全中所目睹的那樣,軍隊願意採取一些可怕的行動,而且他們極易犯錯。如今,AI在軍事領域的應用正在迅速發展。並且,任何政府通過的安全監管措施,默認情況下都會豁免本國軍隊以及與軍隊密切合作的公司。應對策略:盡管如此,這些論點並非讓我們束手無策的理由。相反,我們可以將它們作爲指引,嘗試制定引發這些擔憂最少的規則。策略1:責任如果某人的行爲以某種方式造成了可依法追究的損害,他們可能會被起訴。這並不能解決來自軍隊和其他"凌駕於法律之上"的行爲者所帶來的風險問題,但這是一種非常通用的方法,可避免過度擬合,正因如此,傾向於自由意志主義的經濟學家通常支持這種做法。到目前爲止所考慮的主要責任目標如下:- 用戶:即使用AI的人。- 部署者:爲用戶提供AI服務的中間人。- 開發者:構建AI的人。將責任歸於用戶似乎最符合激勵機制。雖然模型的開發方式與最終使用方式之間的聯繫往往不明確,但用戶決定了AI的具體使用方式。對用戶追究責任會產生一種強大的壓力,促使人們以我認爲正確的方式使用AI:專注於爲人類思維構建機械套裝,而非創造新的自我維持的智能生命形式。策略2:工業規模硬件上的全球"軟暫停"按鈕如果我確信我們需要比責任規則更"強有力"的措施,我會選擇這個策略。目標是在關鍵時期具備將全球可用計算能力降低約90%-99%的能力,持續1-2年,爲人類爭取更多準備時間。1-2年的價值不應被高估:一年的"戰時模式"在自滿的情況下很容易抵得上一百年的常規工作。一種更先進的方法是使用巧妙的加密技術手段:例如,生產出來的工業規模(但非消費級)AI硬件可以配備一個可信硬件芯片,只有在每週獲得來自主要國際機構的3/3籤名時,才允許其繼續運行。這些籤名將與設備無關,所以這將是全有或全無的:沒有實際方法可以授權一個設備繼續運行而不授權所有其他設備。d/acc技術在AI風險中的作用:這兩種策略(責任和硬件暫停按鈕)都存在漏洞,並且很明顯它們只是暫時的權宜之計。因此,我們需要更穩定的措施來爭取時間。許多d/acc技術在這裏是相關的。我們可以如下看待d/acc技術的作用:如果AI接管世界,它會如何做到?- 它入侵我們的計算機→網路防御-

d/acc一周年:去中心化防御加速的進展與挑戰

d/acc:一年後的回顧與展望

去年,我寫了一篇關於技術樂觀主義的文章,闡述了我對技術的熱情以及它可能帶來的巨大效益,同時也表達了對一些特定問題的審慎態度,尤其是超級智能AI可能帶來的風險。

文章的核心觀點是倡導一種去中心化、民主且差異化的防御性加速理念。既要加速技術發展,又要有針對性地關注那些能提升防御能力而非破壞能力的技術,並致力於分散權力,避免權力集中在少數精英手中。

一年過去了,這些想法有了顯著的發展和成熟。我在"80,000小時"平台上分享了這些想法,收到了很多反饋,大多是積極的,當然也有一些批評。

這項工作持續推進並取得了實質性成果:可驗證開源疫苗領域有了進展;人們對健康室內空氣價值的認知不斷深化;"社區筆記"持續發揮積極作用;預測市場作爲信息工具迎來了突破之年;零知識證明在政府身分識別和社交媒體領域得到應用;開源成像工具在醫學和腦機接口領域獲得應用,等等。

去年秋季,我們舉辦了首個重要的d/acc活動:"d/acc發現日"。活動匯聚了來自d/acc各個領域(生物、物理、網路、信息防御和神經技術)的演講者。長期致力於這些技術的人們更好地了解了彼此的工作,外部人士也越來越意識到這一更宏大的願景:推動以太坊和加密貨幣發展的價值觀可以拓展到更廣闊的世界。

d/acc的內涵與外延

d/acc的核心思想簡潔明了:去中心化、民主且差異化的防御性加速。構建能夠促使攻防平衡向防御傾斜的技術,並且在實施過程中不依賴於將更多權力交予中央權威機構。這兩個方面之間存在着內在的緊密聯繫:任何一種去中心化、民主或自由的政治結構,在防御易於實施時往往能夠蓬勃發展,而在防御面臨重重困難時則會遭遇嚴峻挑戰。

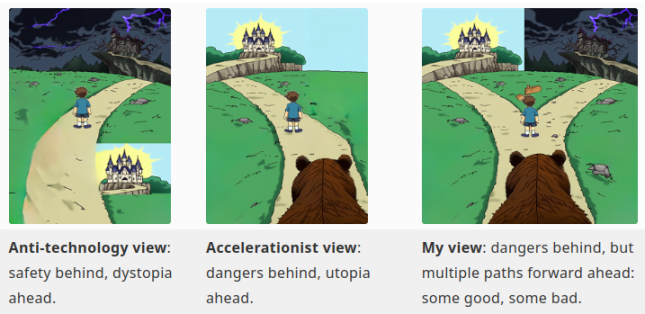

理解嘗試同時實現去中心化、防御性和加速性的重要意義的一種方式,是將其與放棄這三個方面中的任意一個所產生的理念進行對比。

去中心化加速,但忽視"差異化防御"部分,這類似於成爲一名有效加速主義者(e/acc),但同時追求去中心化。這種方式或許能夠避免特定羣體對全球人類實施獨裁統治的風險,但它未能解決潛在的結構性問題:在一個有利於進攻的環境中,始終存在着災難降臨的持續風險,或者有人會將自己定位爲保護者,並永久性地佔據統治地位。

差異化防御加速,但忽略"去中心化和民主",爲了實現安全目標而接受集中控制,這對一部分人始終具有一定的吸引力。然而,集中控制存在一個程度的問題。一種通常被忽視但仍然有害的相對溫和的集中控制形式,體現在生物技術領域對公衆監督的抵制,以及允許這種抵制行爲不受挑戰的閉源規範。

去中心化防御,但排斥加速,這本質上是試圖減緩技術進步或推動經濟衰退。這種策略面臨着雙重挑戰。首先,總體而言,技術和經濟增長對人類而言是極爲有益的,任何對其的延遲都會帶來難以估量的代價。其次,在一個非極權主義的世界中,停滯不前是不穩定的:那些"作弊"最多,能夠找到看似合理的方式繼續推進發展的人或羣體將會佔據優勢。

通過d/acc,我們致力於實現以下目標:

思考d/acc的另一種視角是回歸到21世紀00年代末歐洲海盜黨運動的一個框架:賦權。我們的目標是構建一個能夠保留人類能動性的世界,實現消極自由,即避免他人對我們塑造自身命運的能力進行積極幹預,同時實現積極自由,即確保我們擁有知識和資源去踐行這一能力。

第三維度:生存與繁榮的協同發展

在去年的文章中,d/acc特別聚焦於防御性技術:物理防御、生物防御、網路防御和信息防御。然而,單純的去中心化防御並不足以構建一個偉大的世界:我們還需要一個具有前瞻性的積極願景,明確人類在獲得新的去中心化和安全性之後能夠實現何種目標。

在各個領域中存在着一個一致的模式,即那些能夠幫助我們在某一領域"生存"的科學、思想和工具,與能夠助力我們"繁榮"的科學、思想和工具密切相關。以下是一些具體例子:

除此之外,不同學科領域之間還存在着重要的相互依存關係:

難題:AI安全、緊迫時間線與監管困境

去年我的文章所收到的最具說服力的反對觀點來自AI安全社區。其論點爲:"雖然我們有半個世紀的時間來發展強AI,我們可以集中精力構建所有這些有益的事物。但實際上,看起來我們可能僅有三年時間發展到通用AI,再過三年發展到超級智能。因此,如果我們不想讓世界陷入毀滅或以其他方式陷入不可逆轉的困境,我們不能僅僅加速有益技術的發展,還必須減緩有害技術的發展,這意味着需要通過可能會觸怒權勢階層的強有力監管措施。"

對新監管持謹慎態度的理由:

去年,主要的AI監管提案是加利福尼亞州的SB-1047法案。SB-1047要求最強大模型的開發者在發布前採取一系列安全測試措施。此外,如果AI模型開發者未能足夠謹慎,將對其追究責任。許多批評者認爲該法案"對開源構成威脅";我對此持有異議,因爲成本閾值意味着它僅影響最強大的模型。然而,回顧過去,我認爲該法案存在一個更爲嚴重的問題:如同大多數監管措施一樣,它過度適應了當前的情況。

最有可能對AI超級智能毀滅場景負責的行爲者:

實際上,最有可能對AI超級智能毀滅場景負責的行爲者是軍隊。正如我們在過去半個世紀的生物安全中所目睹的那樣,軍隊願意採取一些可怕的行動,而且他們極易犯錯。如今,AI在軍事領域的應用正在迅速發展。並且,任何政府通過的安全監管措施,默認情況下都會豁免本國軍隊以及與軍隊密切合作的公司。

應對策略:

盡管如此,這些論點並非讓我們束手無策的理由。相反,我們可以將它們作爲指引,嘗試制定引發這些擔憂最少的規則。

策略1:責任

如果某人的行爲以某種方式造成了可依法追究的損害,他們可能會被起訴。這並不能解決來自軍隊和其他"凌駕於法律之上"的行爲者所帶來的風險問題,但這是一種非常通用的方法,可避免過度擬合,正因如此,傾向於自由意志主義的經濟學家通常支持這種做法。

到目前爲止所考慮的主要責任目標如下:

將責任歸於用戶似乎最符合激勵機制。雖然模型的開發方式與最終使用方式之間的聯繫往往不明確,但用戶決定了AI的具體使用方式。對用戶追究責任會產生一種強大的壓力,促使人們以我認爲正確的方式使用AI:專注於爲人類思維構建機械套裝,而非創造新的自我維持的智能生命形式。

策略2:工業規模硬件上的全球"軟暫停"按鈕

如果我確信我們需要比責任規則更"強有力"的措施,我會選擇這個策略。目標是在關鍵時期具備將全球可用計算能力降低約90%-99%的能力,持續1-2年,爲人類爭取更多準備時間。1-2年的價值不應被高估:一年的"戰時模式"在自滿的情況下很容易抵得上一百年的常規工作。

一種更先進的方法是使用巧妙的加密技術手段:例如,生產出來的工業規模(但非消費級)AI硬件可以配備一個可信硬件芯片,只有在每週獲得來自主要國際機構的3/3籤名時,才允許其繼續運行。這些籤名將與設備無關,所以這將是全有或全無的:沒有實際方法可以授權一個設備繼續運行而不授權所有其他設備。

d/acc技術在AI風險中的作用:

這兩種策略(責任和硬件暫停按鈕)都存在漏洞,並且很明顯它們只是暫時的權宜之計。因此,我們需要更穩定的措施來爭取時間。許多d/acc技術在這裏是相關的。我們可以如下看待d/acc技術的作用:如果AI接管世界,它會如何做到?